关于我们

成都创生文化传播有限公司成立于2014年,是中国领先的文化战略专家与商业写作机构,由财经作家、出版人、资深媒体人联合创办,为地方政府、500强企业及头部企业、个人IP提供文化研究与图书创作出版服务,包括华为、腾讯、兴业银行、成都农商银行、通威、茅台、五粮液、洋河、习酒、娃哈哈、吉利、万向、传化等,并为褚时健家族与褚橙品牌、多位个人IP打造品牌。

1956年的达特茅斯会议上,科学家们满怀憧憬地宣告了人工智能的诞生。秉承着符号主义的研究人员们认定,只要将所有的知识都编辑成对应的符号体系,只要算力足够强大,算法足够精妙,那么机器就可以遵循逻辑规则,完成任何任务。与会的科学家们设想,只需几十年,机器就能拥有像人一样的智慧,甚至成为人类的“同类”。

沿着这条研究道路,机器人在科学家的帮助下学会了下跳棋、帮助心理治疗,甚至能够开始为人类看病。然而,当这些聪明的智能“大脑”从棋盘和方程式中走出来,面对真实、动态且充满无限变数的物理世界时,它们却显得惊人地脆弱和无助。现实世界充满了模糊、不完整和不断变化的感官信息,没有清晰的规则和有限的状态,这让机器人们无法分辨桌上的杯子是满是空,也无法在不平坦的地面上走出稳定的一步,这些机器人甚至无法赶上一个婴幼儿的水准。

一个似乎与常识相背的现象:人类所独有的高阶智慧能力只需要非常少的计算能力,虽然在人类看来,复杂的逻辑推理和抽象计算极具挑战,但对于计算机来说只需遵循规则,就能在瞬间算出答案;但是无意识的技能和直觉——比如认出朋友的脸,接住一个飞来的球,跨过路边的石子——却需要极其复杂的感知与协调系统、极大的运算能力。人类大脑通过数百万年的进化将这些技能内化为本能,这种本能与机器强大的运算能力之间,似乎隔着一条巨大的鸿沟。

这个悖论敲醒了研究者们对智能本质的重新思考——智能是否仅存于大脑的运算,还是必须扎根于身体与环境的互动?

早在1950年,计算机科学之父艾伦·图灵就在论证机器能否思考时,隐晦地提到了机器与物理世界交互的可能性。上世纪七八十年代,被莫拉维克悖论跘住的研究人员意识到人类的智慧并非仅依赖抽象思考,更需要通过一个具体的、能与世界持续交互的身体来理解物理世界的因果规律。他们开始尝试脱离符号主义道路,重视“身体”对“智能”生成的重要性,“具身智能”(Embodied Artifcial Intelligence)的想法开始萌芽。

1986年,一个名叫罗德尼·布鲁克斯的学者提出了一个非常叛逆的观点“无表征智能”(Intelligence without Representation):智能行为并不一定需要复杂的中央大脑进行统一规划,而是可以直接从智能体与环境之间简单、直接的物理交互中“涌现”(emerge)出来。他以昆虫为例:一只蚂蚁没有宏大的世界地图,也没有复杂的逻辑推理能力,蚂蚁碰到障碍物会立刻绕开也并非出于它仔细思考“我该往左还是往右”,仅仅是触角碰到东西就触发了“转向”的本能——这就是“无表征”,即不依赖于明确的符号化推理逻辑,而依靠直觉、本能、感知、身体经验来完成动作。

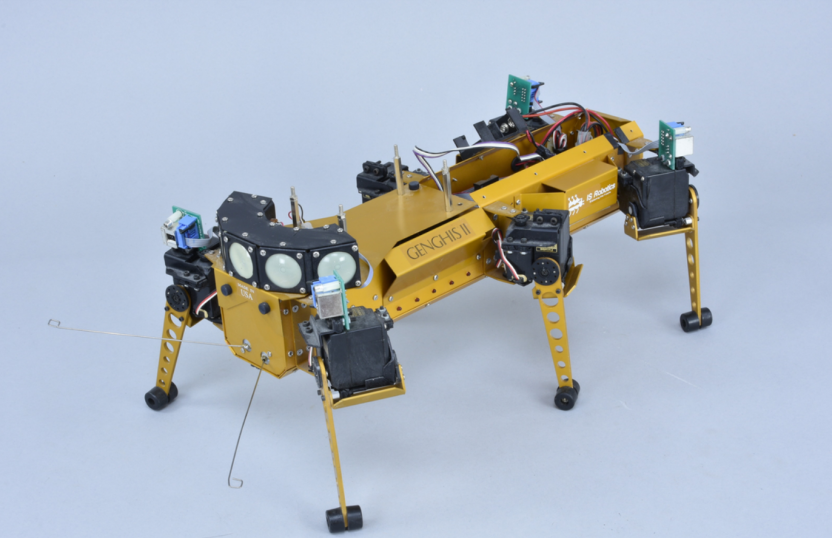

既然如此,那么何必费心为机器人建造一个无比复杂的大脑来模拟全世界呢?为什么不给它一个简单的身体,让它自己去环境里摸爬滚打、学习成长呢?基于这种“无需深思,只管行动”的理念,他造出了机器人昆虫“成吉思(Genghis)”,它没有运力强大的中央“大脑”,只有几个简单的传感器,根据传感器的反馈来执行抬腿、放下腿、摆动身体等简单动作,依靠这套极致简单的行动规则,成吉思能够在协调、稳定地前进爬行,自主越过复杂地形,甚至能跟着人的脚步走。

图为成吉思汗II型机器人

图片来源欧洲数字图书馆

这套逻辑规则后来被罗德尼整合为“包容式架构”的理论,使用这套代码架构,机器人接收到的复杂任务将被分解为一系列简单的基础行动,例如将“打扫全屋”这一系统性指令拆分为“前进并扫地”“遇到障碍物绕开”等具体动作。这在当时堪称革命,它证明了具身智能源于“身体与环境的互动”这一方向的正确性与可行性,为突破莫拉维克悖论提供了第一条切实可行的路径,罗德尼因此被尊为“具身智能之父”。

随后的传感器技术进步给了具身智能第一次大推力。之前的机器人传感器要么太迟钝,碰了东西也没反应;要么太敏感,一点风吹草动就“慌了神”。而90年代出现的微型触觉传感器、高清视觉摄像头,让机器人终于能精准感知世界,触觉传感器能分辨出抓的是鸡蛋还是石头,视觉摄像头能看清地上的小石子。最具代表性的就是日本本田在1996年推出的E2机器人。它第一次模仿人类实现了“稳定行走”,不仅能走直线,还能转弯、上下台阶。虽然E2走得比老人还慢,遇到地上有个纸团就可能绊倒,而且只能在完全平坦的场地里活动,但对当时来说,这已经是“从0到1”的突破:具身智能终于让AI有了“像人一样行动”的雏形。

然而,仅靠条件反射般的直觉行为显然不足以应对所有复杂任务,真正“智能”的机器人还需要能进行一定程度的内部思考、预测和规划。机器人能否在具备身体的情况下,通过不断感知产生的数据,自主学习规则呢?

行动的第一步是“看见”。进入二十一世纪后,计算机硬件、传感器技术、人工智能算法等跨越式的进步,为具身智能提供了可以识别物体的“眼睛”:深度学习。通过大量数据投喂与训练,深度学习帮助机器人精准识别出障碍物、目标物等不同物体,人脸识别、语音识别逐渐成熟,让机器终于能在某些感知任务上媲美甚至超越人类。但这还远远不够。识别出图像是一回事,基于识别去行动又是另一回事。于是,研究者们重新把注意力转向具身智能——机器要动起来,要在现实世界中试错、学习、适应。

2015年之后,具身智能依靠新武器“多模态感知”与“强化学习”,开始朝着适应真实世界发力。“多模态感知”就是让AI同时拥有“眼睛”(视觉)、“手”(触觉)、“耳朵”(听觉),比如看到杯子的同时,能摸到它的温度和光滑度,还能听到自己抓握时的声音,判断有没有抓稳。而“强化学习”就是让AI在试错中进步。在此之前,机器人动作都是研究者编好的,比如E2的每一步膝盖弯曲角度、脚掌落地力度,都是工程师一点点调好的,换个环境就无法适用。而装备了强化学习的机器人可以通过摄像头、激光雷达、触觉传感器等不断收集环境数据,同时记录下自己执行的动作及其产生的后果。利用神经网络这一强大的工具,它可以从这些数据中学习到极其复杂的映射关系,比如怎样的图像特征意味着“可抓取”,怎样的电机指令会导致“成功拿起”。

譬如谷歌的RT-2机器人,第一次拿盘子时把旁边的勺子碰掉了,它就会记住“下次要先把勺子移开”;抓杯子太用力把水洒了,下次就会减轻力度。2022年的RT-2甚至能在杂乱的厨房里,准确找到酱油瓶,还能避开旁边的洗洁精。“莫拉维克悖论”在当下的具身智能面前,不再是难题。

同一时期,开源平台的出现让具身智能的发展速度翻了倍。其中最有名的就是ROS(机器人操作系统),它就像程序中的微软电脑系统,每个研究者不用再从零开始撰写让电脑启动、运行的代码,而是可以直接在微软系统的基础上研究游戏、图像、通信等各行各业的软件。ROS同理,开发者们不必钻研电机驱动、传感器读取等基础应用,可以将更多精力与创意投身让机器人动作更灵活、语言系统更精进。这种标准化、模块化的分工合作让很多小团队也能参与到具身智能的研究里,2018年到2020年这两年,公开的具身智能实验数据比之前十年加起来还多,这些成果的组合让具身智能的技术创新变得更高效、更多元。

然而,突破“莫拉维克悖论”的过程依然艰难。现实世界的复杂性远超实验室的“温室”环境,天气、光线、物体材质的任何一点微小变动,都会打乱机器的判断。机器人需要大量与真实环境的互动才能强化认知,但这些真实环境中的训练复杂且成本高昂。

一个强大的新工具出现了——高度模拟的物理仿真环境。在这些虚拟世界里,时间可以加速,数据可以无限生成,机器人可以毫无风险地进行数百万次的跌倒和碰撞,成千上万个智能体可以同时训练、并行探索,研究人员们再将这些实践出的经验迁移到真实的物理机器人身上。这大大加速了学习进程,解决了在现实世界中训练成本极高、效率低下的瓶颈。

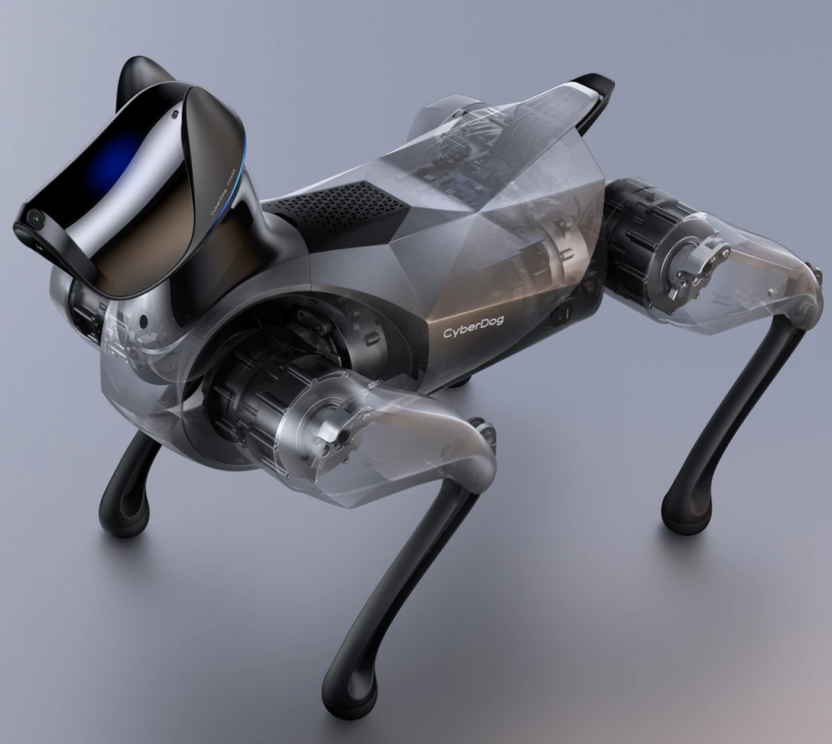

2020年后,具身智能终于从实验室走进了我们的生活。小米推出的Cyber Dog2,个头像个小宠物狗,能跟着主人在小区里散步,遇到台阶会自己跳,碰到行人会主动绕开;医院里的配送机器人,能推着药车准确找到病房,还能根据护士的指令调整药车高度。

而随着近年来大型语言模型的异军突起,具身智能又迎来了新一轮技术突破。计算机视觉、自然语言处理和机器人学这三大领域前所未有地紧密融合在一起。这意味着,机器人不仅拥有了能够看懂世界的眼睛,和能够与世界互动的“肢体”,更拥有了能够听懂人类自然语言指令、并进行复杂推理和规划的“大脑”。一个完整的“感知-认知-行为”(Perception-Cognition-Behavior)闭环正在形成,它让机器人能够准确理解指令中的物体、属性和空间关系,并自主规划和执行一系列动作来完成任务——几乎像人类一样灵活。

图为小米CyberDog2仿生四足机器人

图片来源小米官网

现在回头看,具身智能的发展其实就是一部让智能变“笨”的历史,被寄予厚望的机器人们从动用强大算力为人类突破科学难题的高智商帮手,一步步变成一个刚拥有身体的“婴儿”,从最基础的看、听、触摸、行走开始构建起对世界的认知,将低层的感知运动技能与高层的符号推理更自然地融合起来,成为人类真正的“同类”。

众多科幻片中对未来机器人的想象,可以说已经上升到哲学层面,拥有细腻情感、复杂思维的机器人们在一系列存在主义问题面前踯躅,这一切的前提都是机器人需要拥有一颗真正的智能“大脑”。

在上一部分内容,创生文化团队写到,符号主义领导下的机器人只在特定领域表现出智慧,在瞬息万变的现实世界面前仍然过分笨拙。单一线性的符号推理无法生成智能,科学家不断探索新的思路。人类拥有智慧,是因为拥有大脑中数百亿个神经元,神经元之间的信号传输使人类能够记忆与学习,计算机有没有可能学习这种形式呢?

1946年,沃伦·麦卡洛克和沃尔特·皮茨两位科学家提出了“人工神经网络”的概念。1956年,第一个人工神经元——感知器就此诞生,它能够根据输入的信息给出简单判断,然而对于更复杂的非线性问题就束手无策。1969年,人工智能领域的两位权威马文·明斯基和西摩·帕普特发表了著作《感知机》,详细分析了单层神经网络的局限性,指出仅靠增加神经元数量也无法解决异或等这类非线性问题,给当时火热的神经网络研究泼了一盆冷水,许多研究者开始质疑模拟大脑的思路。

1974年,一位名叫保罗·沃博斯的研究生在哈佛大学完成了一篇博士论文,提出了反向传播算法(Back Propagation Algorithm,简称BP算法)的雏形。BP算法旨在让神经网络先正向计算输出,再将误差从输出层反向传回输入层,逐层调整各连接权重,从而降低整体误差,简而言之,神经网络能够自主学习,“知错就改”了。1986年,杰弗里·辛顿的文章《通过误差反向传播学习表征》(Learning Representations by Back Propagation errors)进一步优化了BP算法,可以说是代表着其首次被引入到多层神经网络训练。研究者们惊讶地发现,机器居然能靠这种方法自行优化,慢慢掌握更复杂的模式。虽然它依旧稚嫩,却已不再是单调的功能机,而是多了一点点像“学习者”的味道。

这一时期还涌现出许多重要的神经网络模型和应用。1989年,来自加拿大的年轻科学家杨立昆将卷积神经网络(CNN)应用于手写数字识别,开发出了LeNet-5模型。CNN模仿了人类视觉神经的感受野机制,通过识别出图像中的局部特征如笔画中的横、折、交点等,并将这些小特征拼成完整的样子。基于此,LeNet-5的工作原理便是先提取数字的笔画边缘、拐角这些小特征,再组合判断是0到9里的哪个数,得以识别支票上手写的账号数字,比以往靠人工辨别效率大幅提高。这一下就让神经网络有了正经的商业用途,成了它从实验室走向实际应用的重要里程碑。

图为“卷积神经网络之父”杨立昆(Yann LeCun)

图片来源TechCrunch官网

几乎同期的另一种神经网络,普通循环神经网络(RNN)在处理长序列数据时会“梯度消失”,也就是说,RNN记不住长信息,像是记忆力衰退的老年人,处理一段长文字,前面的内容对后面的影响会越来越弱,最后完全没印象。学者施密德胡贝尔和霍赫赖特引入“遗忘门”“输入门”等机制,提出了长短期记忆网络(LSTM)。它就像给神经网络们装了个“智能记忆开关”,告诉它们哪些可以忘记,哪些必须记住。LSTM在语音识别和机器翻译等序列任务上表现优异,一度成为21世纪初处理时间序列数据的首选模型。

可以说,80年代末到90年代的这些技术突破,为神经网络从简单的两层模型迈向更深层次的“大脑”奠定了基础。

但受限于此时的硬件水准,仅有简易感知器模型的各类神经网络现在还仅能做一些基础分类,无法进一步深入思考。尽管后续研究人员仍然在不断尝试优化,比如增加神经网络的层数以处理更多种类的信息,但这依旧没有改变它受到冷落的命运。硬件技术的进步是如此地至关重要,到底什么样的硬件能够支撑神经网络的发展?

21世纪的GPU给出了答案。GPU,全称Graphics Processing Unit(图形处理单元),1999年由现在的半导体巨头英伟达公司开发出的一种用于处理图像和图形运算工作的协处理器。它最大的特点就是采用了并行计算架构,可以同时处理大量的简单任务,就像一个个只传输简单电信号的微小神经元。研究人员一次性喂给神经网络大量训练数据,GPU驱动的神经网络可以同时分析所有数据,并一次性使用BP算法调整“思路”——这便是形成智能的大杀器“深度学习”的雏形。

2006年,深度学习概念横空出世。在AI教父杰弗里·辛顿等人的研究突破下,神经网络的层数被无限拉长,从几层变成几十层甚至上百层的“深度”,机器的理解力拔地而起。这一新概念的威力在2012年的ImageNet图像识别大赛上得到了淋漓尽致的展现。这一年,由辛顿教授的学生亚历克斯·克里泽夫斯基等人设计的AlexNet模型横空出世。AlexNet是一个8层的卷积神经网络,它利用GPU加速训练,在120万张高分辨率图像上学习视觉特征,以碾压性的低识别错误率夺得冠军。这个成绩不仅远远超过了当时第二名的算法,更首次让机器在图像识别上接近了人类的水平。

AlexNet的成功震惊了业界,被视为深度学习崛起的标志性事件——它证明了只要有足够的数据和算力,深度神经网络完全可以胜任复杂的感知任务。此后,深度学习在计算机视觉领域势如破竹:2014年的VGG网络和GoogLeNet进一步加深了网络结构;2015年的残差网络(ResNet)解决了深层网络训练退化的问题,使网络深度达到了惊人的152层。到2015年,深度卷积网络在ImageNet上的识别准确率已经超越了人类平均水平,标志着机器视觉能力的一次飞跃。

深度学习的兴起,让计算机在理解语言方面出现了突破。过去的语言模型主要依靠统计规律,难以真正理解长句子。2013年,研究者提出了 Word2Vec,它能把词语转化为“向量”,词义的远近转化为了“向量”地图上位置的远近,计算机第一次能通过“位置”感受到词与词之间的语义关系。随后出现的Seq2Seq模型则像一对翻译搭档:一个网络负责把句子压缩成信息,另一个负责把信息重新生成到另一种语言。为了让翻译更准确,科学家又加上了 注意力机制,让模型像人一样在读句子时“盯住”重点词,从而解决长句翻译的难题。

真正的转折点来自2017年的Transformer。它完全抛弃了传统的循环处理方式,依靠自注意力机制,能在处理一个词时直接参考句子里所有词的信息,就像读书时不必一字一字看,而是能随时跳到关键段落。Transformer不仅提升了理解力,还能同时处理大量数据,大幅加快训练速度。一经推出,就在翻译任务上刷新纪录,并迅速成为之后所有大模型的基础。

在Transformer之后,大模型迎来了爆发。2018年的BERT让计算机能通过预训练掌握语义,再应用到各种任务上;同年OpenAI推出GPT-1,能根据提示生成自然连贯的文本。2019年的GPT-2拥有15亿参数,生成新闻般的文章不在话下,引发了人们对AI写作的震惊。真正让AI“大脑”走向大众的是2020年的GPT-3,参数达1750亿,能写作、答题、翻译,甚至写代码,被称为“通用基础模型”,它让人第一次感觉AI似乎具备了某种通用智能的雏形。

与此同时,AI“大脑”还在其他领域展现了创造与决策的能力。比如GAN(生成对抗网络),通过两个网络互相“较劲”,让计算机学会了画逼真的图像、生成音乐甚至合成人声;再如Alpha Go,结合深度学习和搜索算法,在围棋上战胜世界冠军,展示了AI通过不断试错掌握复杂决策的潜力。

这些进展让人类真正看见,AI不再只是“功能机”式的工具,而是逐渐进化出一个能够理解、创造和抉择的“智能大脑”。

值得一提的是,深度学习的发展也离不开硬件和数据的支撑。在硬件方面,GPU、TPU等专用加速芯片的出现,使得训练大规模神经网络成为可能;分布式计算框架的发展,让成千上万台计算机可以协同训练超大型模型。在数据方面,互联网的繁荣带来了前所未有的海量标注和未标注数据,为模型提供了丰富的“食粮”。可以说,正是算法+算力+数据这三驾马车的齐头并进,才推动人工智能在近十年来取得了飞跃式的进步。

(上篇完)

本文作者

马玥

财经作家,中央民族大学法学学士、中国人民大学文学硕士。中国内容行业的重要研究者和实践者,白酒行业观察家,出版策划人,目前为优质内容创作与出版运作机构创生文化总经理。

持续研究的内容案例包括褚时建与褚橙品牌、浙商企业家精神、茅台文化、五粮液文化等。著有《爆品思维》《褚时健管理法》《重新理解人力资源》《笃信致远:曾康霖》《读懂中国金融》等商业财经、人物传记及学术思想作品,深度研究白酒、金融、新能源等行业史与企业史,联合著作及参与文化项目《兴业之路》《蓉光——成都农商银行口述历史访谈》《这就是茅台》《在这里读懂习酒》及茅台“五力”等企业作品。

蔡维熹

上海师范大学文学学士、四川大学文学硕士,创生文化研究员兼财经作者。

参考文献

[1] 1952年,IBM的阿瑟・塞缪尔编写出跳棋程序,该程序的下棋水平可以通过学习提高,是符号主义实现智能的早期实践。

[2] 1966年,约瑟夫・魏岑鲍姆开发出首个能模拟心理治疗的聊天机器人ELIZA,已能让测试者产生情感依赖,展示了符号主义在自然语言处理方面的初步成果。

[3] 1972年,斯坦福大学推出用于医学诊断的MYCIN专家系统,通过编码数百条医疗规则,能够根据症状给出疾病和处方建议,其准确率超过人类专家,是符号主义在医疗领域应用的成功案例。

[4] Turing A M .Computing machinery and intelligence[J].Mind, 1950.

[5] Brooks R.A robust layered control system for a mobile robot[J].IEEE J.robot.autom,1986.

[6]Werbos P.Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences [J].Ph.d.dissertation Harvard University, 1974.

[7]协处理器:指协助中央处理器完成其无法执行或执行效率、效果低下的处理工作的处理器。

[8](印)阿卡普拉沃·包米克著.王兆天,李晔卓译.机器意识:人工智能如何为机器人装上大脑[M].机械工业出版社,2010.

[9]Rabiner L R .A tutorial on hidden Markov models and selected applications in speech recognition[J].Proc IEEE,1989.

[10]Okada T.Object-Handling System for Manual Industry[J].Systems Man & Cybernetics IEEE Transactions on, 1979.

https://mp.weixin.qq.com/s/8y63e_V1A5wgsUjKIOJz0w

2025年,人形机器人产业迎来爆发拐点。特斯拉Optimus量产在即,华为、宇树等企业加速技术突破,行业正从“实验室研发”向“规模化落地”跃迁为打通产业链上下游协作壁垒,艾邦机器人正式组建"人形机器人全产业链交流群",覆盖金属材料、复合材料、传感器、电机、减速器等全硬件环节,助力企业精准对接资源、共享前沿技术!

扫码关注公众号,底部菜单申请进群